Diferencia entre revisiones de «Usando Taller»

(Ajustes gramaticales, del sentido y del contenido) |

|||

| Línea 72: | Línea 72: | ||

=== Calificación por envío === | === Calificación por envío === | ||

La calificación final para cada | La calificación final para cada tarea enviada se calcula según la media ponderada de las de evaluaciones particulares dadas por todos los revisores de lo recibido. El valor se redondea al número de (lugares) decimales establecido en la configuración del Taller. | ||

El docente del curso pueden influir de dos maneras en la calificación: | |||

* al proporcionar su propia evaluación, | * al proporcionar su propia evaluación, generalmente con una ponderación mayor que el peso de las de los pares evaluadores | ||

* al | * al llevar la calificación a un valor dado | ||

=== Calificación por evaluación === | === Calificación por evaluación === | ||

La calificación por evaluación intenta estimar la calidad de | La calificación por evaluación intenta estimar la calidad de las evaluaciones que el participante le asigna a los pares. Esta calificación (también conocida como "calificando la calificación") la calcula la Inteligencia Artificial oculta dentro del módulo de Taller que procura realizar la típica tarea docente. | ||

Durante la fase de calificación de la evaluación, se usa un sub-plugin del Taller para calcular calificaciones por evaluación. Actualmente, solo está disponible un sub-plugin estándar llamado Comparación con la mejor evaluación ''Comparison with the best assessment'' (pueden encontrarse otros suplementos de evaluación en el directorio de aplicaciones de Moodle [https://moodle.org/plugins/browse.php?list=category&id=17 Moodle). El siguiente texto describe el método usado por este sub-plugin. | |||

Las calificaciones por evaluación aparecen entre paréntesis () en el Reporte de calificaciones del Taller. La calificación final por evaluación se calcula como el promedio de calificaciones evaluadas por particulares. | |||

No existe una fórmula única para describir el cálculo. Sin embargo, el proceso es determinístico. El Taller elige a una de las evaluaciones como la ''mejor'' - la más cercana a la media de todas las evaluaciones - y le otorga una calificación del 100%. Entonces mide la 'distancia' de todas las demás evaluaciones a esta mejor evaluación y les otorga calificaciones más baja, cuanto más distantes estén de la mejor (dado que la mejor representa un consenso de la mayoría de los evaluadores). El parámetro del cálculo es cuán estricto deberíamos ser, lo que implica cuán rápidamente caerán las calificaciones si difieren de la mejor. | |||

Si hubiera solo dos evaluaciones por envío, el Taller no puede decidir cual de ellas es 'correcta'. Imaginemos que se tienen dos revisores - Alicia y Bob. Ambos evalúan el envío de Cindy. Alicia dice que es deplorable y Bob, que es excelente. No hay forma de decidir quien está en lo correcto. Por eso, el Taller simplemente dice - bueno, ambos tiene razón y les voy a dar a ambos dos calificación del 100% para esta evaluación. Para evitar que ocurra esto, se cuenta con dos opciones: | |||

* proporcionar una evaluación adicional para que su número sea impar y el taller pueda elegir al mejor. Típicamente el docente proporciona su propia evaluación para juzgar el envío | |||

* O se puede decidir un grado de confianza dispar, mayor para uno de los revisores. Por ejemplo, si se sabe que Alicia es mucho mejor evaluadora que Bob, se le puede aumentar la ponderación a la evaluación de Alicia, digamos que a "2" (en lugar del ajuste por defecto de "1"). A los propósitos del cálculo, la evaluación de Alicia será considerada como si hubiera dos revisores que tienen exactamente la misma opinión y por lo tanto es más probable que sean elegidos como el mejor. | |||

* | |||

* O | |||

'''Nota de Retro-compatibilidad''' | '''Nota de Retro-compatibilidad''' | ||

En la versión de Taller 1.x | En la versión de Taller 1.x el caso de dos evaluadores con la misma ponderación no es manejado apropiadamente y conduce a resultados erróneos ya que solo uno de ellos es afortunado de obtener 100% y el segundo obtiene una calificación más baja. | ||

'''No son las calificaciones finales las que | '''No son las calificaciones finales las que se comparan''' | ||

{{Pendiente de traducir}} | {{Pendiente de traducir}} | ||

It is very important to know that the grading evaluation subplugin ''Comparison with the best assessment'' does not compare the final grades. Regardless the grading strategy used, every filled assessment form can be seen as n-dimensional vector of normalized values. So the subplugin compares responses to all assessment form dimensions (criteria, assertions, ...). Then it calculates the distance of two assessments, using the variance statistics. | It is very important to know that the grading evaluation subplugin ''Comparison with the best assessment'' does not compare the final grades. Regardless the grading strategy used, every filled assessment form can be seen as n-dimensional vector of normalized values. So the subplugin compares responses to all assessment form dimensions (criteria, assertions, ...). Then it calculates the distance of two assessments, using the variance statistics. | ||

Revisión del 19:30 1 ago 2019

Fases del taller

El flujo del trabajo para el módulo de Taller puede considerarse compuesto de cinco fases. La actividad típica de Taller puede desarrollarse a lo largo de varios días e incluso semanas. El docente puede modificar la actividad de una fase a otra.

El taller típico sigue una recorrido lineal desde la Configuración a, Envío, Valoración, Calificación/Evaluación, y finalizar con la condición de Cerrado. Sin embargo, también es posible una ruta de avances recursivos.

El progreso de la actividad es visualizado a través de la herramienta de planeamiento del Taller. Muestra todas sus fases y resalta la fase actual. También lista todos los trabajos de cada usuario en la fase actual, con la información acerca de si el trabajo está terminado o no e incluso, reprobado/fallido.

Fase de configuración

En esta fase inicial, sólo intervienen los facilitadores del curso, cambiando las configuraciones del Taller, modificandi la estrategia para calificar o ajustando los formatos (formularios) de evaluación. Los destinatarios no pueden participar del taller en esta fase: ni siquiera pueden modificar sus envíos o sus evaluaciones. Los facilitadores pueden pasar a esta fase en cualquier momento si es que necesitan cambiar las configuraciones del Taller y evitar que los usuarios modifiquen sus trabajos.

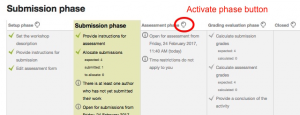

Fase de envío

En la fase de envío, los participantes del Taller envían su trabajo. Las fechas para control del acceso pueden configurarse de forma tal que aun y cuando el taller estuviera en esta fase, el envío está restringido a solamente al marco de tiempo dado. La fecha (y hora) de inicio del envío, la fecha ( y hora) de fin, o ambas, pueden especificarse.

¡Nueva característica

en Moodle 3.0!

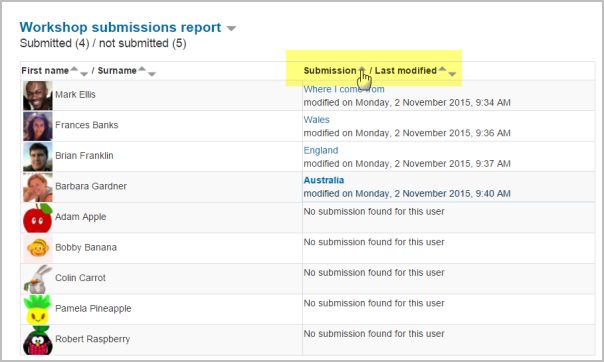

El reporte de envíos del taller le permite a los profesores ver quienes han enviado y quienes no han enviado su trabajo, y filtrar por envío y por última modificación:

¡Nueva característica

en Moodle 3.1!

Un estudiante puede eliminar sus envíos propios siempre y cuando el estudiante pueda editarlos y que aun no hayan sido evaluados. Un profesor puede eliminar cualquier envío en cualquier momento; sin embargo, si ya hubiera sido evaluado, al profesor se le advertirá que también se eliminará la evaluación y que pueden afectarse las calificaciones de los evaluadores.

Fase de evaluación

Si el Taller usa la característica de evaluación por pares, esta es la fase cuando los participantes del Taller evalúan los envíos que les fueron asignados para revisar. Igual que en la fase de envío, el acceso puede ser controlado por la fecha y hora especificadas en 'desde cuando' y en 'hasta cuando' está permitida la evaluación.

Fase de evaluación de la calificación

El trabajo principal durante esta fase es calcular las calificaciones finales para los envíos y para las evaluaciones y proporcionar retroalimentación para autores y revisores. Los participantes del Taller ya no pueden modificar más sus envíos o sus evaluaciones en esta fase. Los facilitadores del curso pueden anular manualmente las calificaciones calculadas. También, los envíos seleccionados pueden ser configurados como publicados, de forma tal que estén disponibles para todos los participantes del Taller en la siguiente fase. Vea Taller FAQ para las instrucciones sobre como publicar los envíos.

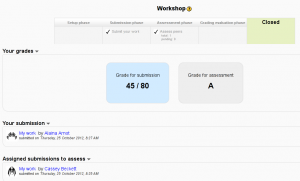

Cerrado

Siempre que el taller sea cambiado hacia esta fase, las calificaciones finales que fueron calculadas en la fase anterior son empujadas al interior del Libro de calificaciones del curso. Esto resultará en que aparezcan las calificaciones del Taller dentro del Libro de calificaciones y dentro del Taller (nuevo a partir de Moodle 2.4 en adelante). Los participantes pueden ver sus envíos, las evaluaciones de sus envíos y eventualmente cualquier otro envío publicado en esta fase.

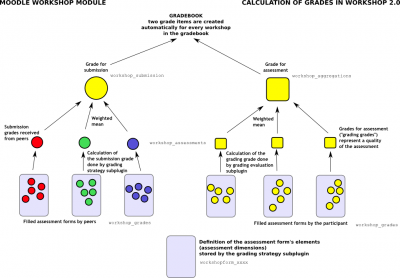

Calificación del taller

Las calificaciones para una actividad de Taller se obtienen gradualmente en diferentes etapas y después son finalizadas. El esquema siguiente ilustra el proceso y también proporciona la información sobre en cuales tablas de la base de datos están almacenadas.

Los participantes obtienen dos calificaciones que son calculadas durante la fase de Calificación de la Evaluación. el profesor puede editar estas calificaciones mientras todavía están en esta fase. No se irán al interior del Libro de calificaciones hasta después de que el taller sea cerrado en la fase final. Tenga en cuenta que es posible moverse entre las fases y aun y cuando el Taller estuviera cerrado, las calificaciones se pueden cambiar directamente adentro del Libro de calificaciones si fuera necesario

La tabla inferior explica como se visualizan las calificaciones:

| Valor | Significado |

|---|---|

| - (-) < Alicia | Hay una valoración asignada por hacer por Alicia, pero no ha sido valorada ni evaluada todavía |

| 68 (-) < Alicia | Alicia valoró el envío, dando la calificación por envío de 68. La calificación por evaluación (calificación por calificar) aun no ha sido evaluada. |

| 23 (-) > Bob | El envío de Bob fue evaluado por un par, recibiendo una calificación por el envío de 23. La calificación para esta evaluación aun no ha sido evaluada. |

| 76 (12) < Cindy | Cindy evaluó el envío, otorgando la calificación de 76. La calificación por esta evaluación ha sido evaluada con 12. |

| 67 (8) @ 4 < David | David evaluó el envío, otorgando la calificación por envío de 67, recibiendo la calificación por esta evaluación de 8. Su evaluación tiene ponderación de 4 |

| 80 ( |

El envío de Eva fue evaluado por un par. El envío de Eva recibió 80 y la calificación por esta evaluación fue calculada en 20. El profesor ha anulado la calificación por calificar a 17, probablemente junto con una explicación para el revisor. |

Calificación por envío

La calificación final para cada tarea enviada se calcula según la media ponderada de las de evaluaciones particulares dadas por todos los revisores de lo recibido. El valor se redondea al número de (lugares) decimales establecido en la configuración del Taller.

El docente del curso pueden influir de dos maneras en la calificación:

- al proporcionar su propia evaluación, generalmente con una ponderación mayor que el peso de las de los pares evaluadores

- al llevar la calificación a un valor dado

Calificación por evaluación

La calificación por evaluación intenta estimar la calidad de las evaluaciones que el participante le asigna a los pares. Esta calificación (también conocida como "calificando la calificación") la calcula la Inteligencia Artificial oculta dentro del módulo de Taller que procura realizar la típica tarea docente. Durante la fase de calificación de la evaluación, se usa un sub-plugin del Taller para calcular calificaciones por evaluación. Actualmente, solo está disponible un sub-plugin estándar llamado Comparación con la mejor evaluación Comparison with the best assessment (pueden encontrarse otros suplementos de evaluación en el directorio de aplicaciones de Moodle [https://moodle.org/plugins/browse.php?list=category&id=17 Moodle). El siguiente texto describe el método usado por este sub-plugin.

Las calificaciones por evaluación aparecen entre paréntesis () en el Reporte de calificaciones del Taller. La calificación final por evaluación se calcula como el promedio de calificaciones evaluadas por particulares.

No existe una fórmula única para describir el cálculo. Sin embargo, el proceso es determinístico. El Taller elige a una de las evaluaciones como la mejor - la más cercana a la media de todas las evaluaciones - y le otorga una calificación del 100%. Entonces mide la 'distancia' de todas las demás evaluaciones a esta mejor evaluación y les otorga calificaciones más baja, cuanto más distantes estén de la mejor (dado que la mejor representa un consenso de la mayoría de los evaluadores). El parámetro del cálculo es cuán estricto deberíamos ser, lo que implica cuán rápidamente caerán las calificaciones si difieren de la mejor.

Si hubiera solo dos evaluaciones por envío, el Taller no puede decidir cual de ellas es 'correcta'. Imaginemos que se tienen dos revisores - Alicia y Bob. Ambos evalúan el envío de Cindy. Alicia dice que es deplorable y Bob, que es excelente. No hay forma de decidir quien está en lo correcto. Por eso, el Taller simplemente dice - bueno, ambos tiene razón y les voy a dar a ambos dos calificación del 100% para esta evaluación. Para evitar que ocurra esto, se cuenta con dos opciones:

- proporcionar una evaluación adicional para que su número sea impar y el taller pueda elegir al mejor. Típicamente el docente proporciona su propia evaluación para juzgar el envío

- O se puede decidir un grado de confianza dispar, mayor para uno de los revisores. Por ejemplo, si se sabe que Alicia es mucho mejor evaluadora que Bob, se le puede aumentar la ponderación a la evaluación de Alicia, digamos que a "2" (en lugar del ajuste por defecto de "1"). A los propósitos del cálculo, la evaluación de Alicia será considerada como si hubiera dos revisores que tienen exactamente la misma opinión y por lo tanto es más probable que sean elegidos como el mejor.

Nota de Retro-compatibilidad

En la versión de Taller 1.x el caso de dos evaluadores con la misma ponderación no es manejado apropiadamente y conduce a resultados erróneos ya que solo uno de ellos es afortunado de obtener 100% y el segundo obtiene una calificación más baja.

No son las calificaciones finales las que se comparan

Nota: Pendiente de Traducir. ¡Anímese a traducir esta página!. ( y otras páginas pendientes)

It is very important to know that the grading evaluation subplugin Comparison with the best assessment does not compare the final grades. Regardless the grading strategy used, every filled assessment form can be seen as n-dimensional vector of normalized values. So the subplugin compares responses to all assessment form dimensions (criteria, assertions, ...). Then it calculates the distance of two assessments, using the variance statistics.

To demonstrate it on example, let us say you use grading strategy Number of errors to peer-assess research essays. This strategy uses a simple list of assertions and the reviewer (assessor) just checks if the given assertion is passed or failed. Let us say you define the assessment form using three criteria:

- Does the author state the goal of the research clearly? (yes/no)

- Is the research methodology described? (yes/no)

- Are references properly cited? (yes/no)

Let us say the author gets 100% grade if all criteria are passed (that is answered "yes" by the assessor), 75% if only two criteria are passed, 25% if only one criterion is passed and 0% if the reviewer gives 'no' for all three statements.

Now imagine the work by Daniel is assessed by three colleagues - Alice, Bob and Cindy. They all give individual responses to the criteria in order:

- Alice: yes / yes / no

- Bob: yes / yes / no

- Cindy: no / yes / yes

As you can see, they all gave 75% grade to the submission. But Alice and Bob agree in individual responses, too, while the responses in Cindy's assessment are different. The evaluation method Comparison with the best assessment tries to imagine, how a hypothetical absolutely fair assessment would look like. In the Development:Workshop 2.0 specification, David refers to it as "how would Zeus assess this submission?" and we estimate it would be something like this (we have no other way):

- Zeus 66% yes / 100% yes / 33% yes

Then we try to find those assessments that are closest to this theoretically objective assessment. We realize that Alice and Bob are the best ones and give 100% grade for assessment to them. Then we calculate how much far Cindy's assessment is from the best one. As you can see, Cindy's response matches the best one in only one criterion of the three so Cindy's grade for assessment will not be as high.

The same logic applies to all other grading strategies, adequately. The conclusion is that the grade given by the best assessor does not need to be the one closest to the average as the assessment are compared at the level of individual responses, not the final grades.

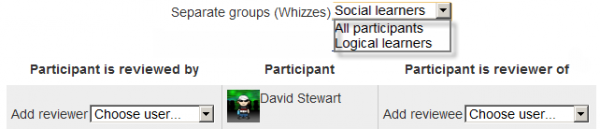

Grupos y Taller

Cuando un Taller es usado en un curso usando Grupos y Agrupamientos visibles o separados, es posible filtrar por grupo en un menú desplegable en la fase de Evaluación, la página de asignación manual, reporte de calificaciones y otras más.

Vea también

- Research paper Moodle Workshop activities support peer review in Year 1 Science: present and future by Julian M Cox, John Paul Posada and Russell Waldron

- Using Moodle Workshop module forum

- Using Moodle forum discussion [1] where David explains a particular Workshop results

- Moodle Workshop 2.0 - a (simplified) explanation presentation by Mark Drechsler

- Development:Workshop for more information on the module infrastructure and ways how to extend provided functionality by developing own Workshop subplugins

- A Brief Journey into the Moodle 2.0 Workshop at moodlefairy's posterous