« Utiliser Atelier » : différence entre les versions

Aucun résumé des modifications |

Aucun résumé des modifications |

||

| Ligne 41 : | Ligne 41 : | ||

==Évaluation de l'atelier== | ==Évaluation de l'atelier== | ||

Les notes pour l'activité Atelier sont obtenues progressivement à travers un processus de saisie et de calcul, puis elles sont finalisées et mémorisée dans le [[ | Les notes pour l'activité Atelier sont obtenues progressivement à travers un processus de saisie et de calcul, puis elles sont finalisées et mémorisée dans le [[Carnet de notes|"Carnet de notes"]]. Le schéma suivant illustre le processus d'élaboration des deux notes finales et fournit également les noms des tables de base de données dans lesquelles les valeurs sont mémorisées. | ||

[[Image:schéma-notes-Atelier.jpg|400px|thumb|left|Schéma d'élaboration et calcul des notes de l'activité Atelier]] | [[Image:schéma-notes-Atelier.jpg|400px|thumb|left|Schéma d'élaboration et calcul des notes de l'activité Atelier]] | ||

| Ligne 47 : | Ligne 47 : | ||

Chaque participant obtient deux notes numériques pendant la phase d'évaluation. Ces notes sont ensuite enregistrée dans le cours "Carnet de notes". Pendant la phase d'évaluation, l'enseignant ou gestionnaire de cours peut laisser le module de l'atelier calculer ces notes finales, ou les éditer lui-même. Notez qu'il est possible de passer d'une phase à l'autre, même lorsque l'atelier a déjà été fermé. Ainsi, après la clôture de l'activité Atelier, vous pourriez y revenir pour annuler ou calculer à nouveau les notes. Une nouvelle fermeture de l'activité Atelier provoquerait la mise à jour des notes dans le cours "Carnet de notes". | |||

Par ailleurs, les notes peuvent être modifiées directement dans le "Carnet de notes" si nécessaire. | |||

| Ligne 80 : | Ligne 81 : | ||

=== Évaluation du travail remis === | === Évaluation du travail remis === | ||

La note finale de chaque travail remis correspond à la moyenne pondérée des notes d'évaluation particulières données par tous les examinateurs. La valeur est arrondie à un nombre de décimales défini dans le formulaire des paramètres de l'atelier. | |||

Le gestionnaire du cours (l'enseignant) peut moduler la note selon deux possibilités : | |||

* En attribuant lui-même une note, à laquelle est fixé un coefficient de pondération supérieur à ceux donnés aux différents pairs examinateurs. | |||

* En corrigeant la note finale elle-même | |||

=== Estimation de l'évaluation des pairs === | |||

La note d'évaluation permet d'estimer la qualité des évaluations que le participant a données ses pairs. Cette note est calculée par une formule cachée dans le module de l'atelier, parce qu'elle est supposée faire un travail dévolu à l'enseignant. | |||

Au cours de la phase d'évaluation des travaux, un sous-module de l'activité Atelier est utilisé pour calculer les notes pour l'évaluation. Actuellement, par défaut, un seul sous-module standard est disponible ; il agit par "comparaison avec la meilleure évaluation". Notez que d'autres plugins d'évaluation de notation peuvent être trouvés dans [https://moodle.org/plugins/browse.php?list=category&id=17|la bibliothèque de modules ou "plugins" de Moodle]). | |||

Voici la méthode utilisée pour le calcul par "comparaison avec la meilleure évaluation" : | |||

Les notes pour l'évaluation sont affichées entre parenthèses () dans le rapport de l'atelier. La note finale pour l'évaluation est calculée comme la moyenne de ces notes particulières. | |||

La formule globale n'est pas simple à décrire, cependant elle est "déterministe" : | |||

# La note la plus proche de la moyenne des notes est considérée comme étant "la meilleure" pas l’algorithme. On suppose que cette note serait consensuelle pour la majorité des examinateurs. | |||

# A cette note de référence est attribué un poids de 100%. | |||

# A chacune des autres notes, on attribue un poids inférieur à 100%, en proportion de l'écart (différence) constaté par rapport à la note de référence ("la meilleure"). | |||

La pertinence du calcul dépend de notre façon d'apprécier le rythme d'arrivée des notes particulières, en corrélation avec les écarts constatés par rapport à la note "la meilleure" : | |||

S'il n'y a que deux évaluations par soumission, l'algorithme ne peut pas décider laquelle d'elles est «la meilleure». Imaginez que vous ayez deux critiques - Alice et Robert. Ils évaluent tous deux la présentation de Jeanne. Alice dit que c'est un travail pitoyable et Robert prétend à l'opposé que c'est excellent. L'algorithme n'a aucun moyen de décider qui est juste. Il attribue simplement une note de 100% à chaque évaluation. Afin d'éviter cela, vous avez deux options : | |||

* Soit vous fournissez une évaluation supplémentaire, de telle sorte que le nombre d'examinateurs devienne impair, et que l'algorithme puisse déterminer une note comme étant "la meilleure". Généralement, l'enseignant fournit sa propre évaluation. | |||

* | * Soit vous décidez de faire davantage confiance à l'un des participants aux évaluations. Par exemple, Alice ayant la réputation de fournir habituellement des évaluations plutôt pertinentes, vous décidez d'augmenter le poids de son évaluation, en le portant à 2 (par défaut, il est de 1). L'évaluation d'Alice sera alors prise en compte deux fois, comme si deux examinateurs avaient exactement la même opinion ; aussi cette évaluation est-elle susceptible d'être choisie comme la meilleure. | ||

'''Backward compatibility note''' | '''Backward compatibility note''' | ||

Version du 17 février 2017 à 15:58

Remarque : la traduction de cette page n'est pas terminée. N'hésitez pas à traduire tout ou partie de cette page ou à la compléter. Vous pouvez aussi utiliser la page de discussion pour vos recommandations et suggestions d'améliorations.

Objet de l'activité Atelier

L'atelier permet l'évaluation par les pairs et contient de nombreuses options permettant des scénarios pédagogiques complexes. Reportez vous à la page dédiée à la présentation de cette activité dans la documentation pour en comprendre l'intérêt.

Étapes de fonctionnement de l'atelier

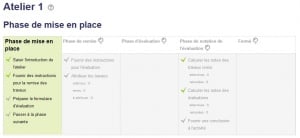

L'activité atelier fonctionne selon un processus en cinq étapes. Le processus complet de travail dans un atelier peut se dérouler sur plusieurs jours voire plusieurs semaines. C'est l’enseignant qui décide de la commutation des différentes phases.

Le travail dans l'atelier suit un processus linéaire passant par les étapes suivantes : Mise en place, Remise des travaux, Évaluation, Notation de l'évaluation, et se termine par l'étape Fermé. Cependant, un processus par itérations successives reste possible.

La progression de l'activité peut être suivie dans l'écran de planification de l'activité. Celui-ci affiche les phases possibles de l'Atelier en surlignant la phase en cours. Les tâches à exécuter par le participant sont listées pour chaque étudiant avec une indication si la tâche est finie, à finir ou éventuellement invalidée.

Étape de mise en place

Dans cette première étape, les participants à l'atelier ne peuvent rien faire (ni corriger les travaux rendus, ni modifier leurs évaluations).

Les enseignants, gestionnaires ou animateurs du cours utilisent cette phase pour configurer les paramètres de l'atelier et définir la stratégie de classement des formulaires d'évaluation. Vous pouvez activer cette étape chaque fois que vous avez besoin de régler les paramètres de l'atelier ou d'empêcher les utilisateurs de modifier leur travail.

Étape de remise des travaux

Dans la phase de remise des travaux, les participants à l'atelier présentent leur travail ("soumission des travaux").

Des dates de contrôle d'accès peuvent être définies de telle sorte que, même si l'Atelier est maintenu dans cette phase, la possibilité de remise des travaux est limitée à la période donnée. Il est possible d'indiquer une date (et heure) de début de remise du travail, ainsi qu'une date de fin, ou les deux.

Étape d'évaluation par les pairs

Si la configuration de l'Atelier prévoit l'évaluation par les pairs, c'est la phase où les participants à l'atelier apprécient les travaux qui leur sont soumis à évaluation.

Comme dans la phase de remise des travaux, l'accès peut être limité par des groupes horaires de début et de fin d'autorisation d'évaluation.

Étape de notation des évaluations

L'objet principal de cette phase est de calculer deux notes finales. En effet, les participants reçoivent une note pour leur travail (calculée sur base des évaluations faites par les différents participants), ainsi qu'une note pour la qualité des évaluations qu'ils ont fournies.

Cette étape permet aussi de fournir les commentaires d'évaluations pour les auteurs et les examinateurs.

Les participants à l'atelier ne peuvent plus modifier leurs soumissions ou leurs évaluations pendant cette phase. Les gestionnaires de cours peuvent annuler manuellement les notes calculées. En outre, les soumissions sélectionnées peuvent être définies comme étant publiées afin qu'elles soient disponibles pour tous les participants à l'atelier dans la phase suivante. Voir Atelier FAQ pour obtenir des instructions sur la façon de publier des soumissions.

Fermeture de l'atelier

Chaque fois que l'Atelier passe à cette phase, les notes finales calculées au cours de la phase précédente sont insérées dans le cours Carnet de notes. Les notes de l'Atelier figurant dans le Carnet de notes et dans l'atelier. Les participants peuvent consulter leurs soumissions, leurs évaluations de soumissions et éventuellement d'autres présentations publiées dans cette phase.

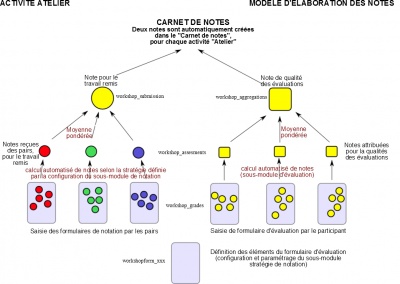

Évaluation de l'atelier

Les notes pour l'activité Atelier sont obtenues progressivement à travers un processus de saisie et de calcul, puis elles sont finalisées et mémorisée dans le "Carnet de notes". Le schéma suivant illustre le processus d'élaboration des deux notes finales et fournit également les noms des tables de base de données dans lesquelles les valeurs sont mémorisées.

Chaque participant obtient deux notes numériques pendant la phase d'évaluation. Ces notes sont ensuite enregistrée dans le cours "Carnet de notes". Pendant la phase d'évaluation, l'enseignant ou gestionnaire de cours peut laisser le module de l'atelier calculer ces notes finales, ou les éditer lui-même. Notez qu'il est possible de passer d'une phase à l'autre, même lorsque l'atelier a déjà été fermé. Ainsi, après la clôture de l'activité Atelier, vous pourriez y revenir pour annuler ou calculer à nouveau les notes. Une nouvelle fermeture de l'activité Atelier provoquerait la mise à jour des notes dans le cours "Carnet de notes".

Par ailleurs, les notes peuvent être modifiées directement dans le "Carnet de notes" si nécessaire.

Pendant l'exercice de notation, le rapport des notes de l'atelier vous donne un aperçu complet de toutes les notes individuelles. Le rapport utilise divers symboles et syntaxes:

| Value | Meaning |

|---|---|

| - (-) < Alice | Un travail remis est soumis à l'évaluation d'Alice (attribution à Alice pour évaluation). Mais Alice n'a pas encore commenté ni noté ce travail. |

| 68 (-) < Alice | Alice a noté le travail avec 68 points. Mais la seconde note pour l'évaluation n'a pas encore été fixée. |

| 23 (-) > Robert | Le travail remis par Robert a été noté par un camarade, qui a attribué 23 points. La note pour cette évaluation n'a pas encore été fixée. |

| 76 (12) < Jeanne | Jeanne a noté le travail, attribuant 76 points. La note pour cette évaluation est fixée à 12. |

| 67 (8) @ 4 < David | David a noté le travail, attribuant 67 points ; la note pour cette évaluation est de 8. Son évaluation a un poids de 4 pour le calcul de la moyenne pondérée. |

| 80 ( |

Le travail remis par Eve a été évalué par un camarade, avec une note de 80. L'évaluation a elle-même été noté à 20, mais l'enseignant a revu à la baisse cette seconde note, la fixant à 17. Il a probablement donné une explication pour justifier cette baisse. |

Évaluation du travail remis

La note finale de chaque travail remis correspond à la moyenne pondérée des notes d'évaluation particulières données par tous les examinateurs. La valeur est arrondie à un nombre de décimales défini dans le formulaire des paramètres de l'atelier.

Le gestionnaire du cours (l'enseignant) peut moduler la note selon deux possibilités :

- En attribuant lui-même une note, à laquelle est fixé un coefficient de pondération supérieur à ceux donnés aux différents pairs examinateurs.

- En corrigeant la note finale elle-même

Estimation de l'évaluation des pairs

La note d'évaluation permet d'estimer la qualité des évaluations que le participant a données ses pairs. Cette note est calculée par une formule cachée dans le module de l'atelier, parce qu'elle est supposée faire un travail dévolu à l'enseignant.

Au cours de la phase d'évaluation des travaux, un sous-module de l'activité Atelier est utilisé pour calculer les notes pour l'évaluation. Actuellement, par défaut, un seul sous-module standard est disponible ; il agit par "comparaison avec la meilleure évaluation". Notez que d'autres plugins d'évaluation de notation peuvent être trouvés dans bibliothèque de modules ou "plugins" de Moodle).

Voici la méthode utilisée pour le calcul par "comparaison avec la meilleure évaluation" :

Les notes pour l'évaluation sont affichées entre parenthèses () dans le rapport de l'atelier. La note finale pour l'évaluation est calculée comme la moyenne de ces notes particulières. La formule globale n'est pas simple à décrire, cependant elle est "déterministe" :

- La note la plus proche de la moyenne des notes est considérée comme étant "la meilleure" pas l’algorithme. On suppose que cette note serait consensuelle pour la majorité des examinateurs.

- A cette note de référence est attribué un poids de 100%.

- A chacune des autres notes, on attribue un poids inférieur à 100%, en proportion de l'écart (différence) constaté par rapport à la note de référence ("la meilleure").

La pertinence du calcul dépend de notre façon d'apprécier le rythme d'arrivée des notes particulières, en corrélation avec les écarts constatés par rapport à la note "la meilleure" :

S'il n'y a que deux évaluations par soumission, l'algorithme ne peut pas décider laquelle d'elles est «la meilleure». Imaginez que vous ayez deux critiques - Alice et Robert. Ils évaluent tous deux la présentation de Jeanne. Alice dit que c'est un travail pitoyable et Robert prétend à l'opposé que c'est excellent. L'algorithme n'a aucun moyen de décider qui est juste. Il attribue simplement une note de 100% à chaque évaluation. Afin d'éviter cela, vous avez deux options :

- Soit vous fournissez une évaluation supplémentaire, de telle sorte que le nombre d'examinateurs devienne impair, et que l'algorithme puisse déterminer une note comme étant "la meilleure". Généralement, l'enseignant fournit sa propre évaluation.

- Soit vous décidez de faire davantage confiance à l'un des participants aux évaluations. Par exemple, Alice ayant la réputation de fournir habituellement des évaluations plutôt pertinentes, vous décidez d'augmenter le poids de son évaluation, en le portant à 2 (par défaut, il est de 1). L'évaluation d'Alice sera alors prise en compte deux fois, comme si deux examinateurs avaient exactement la même opinion ; aussi cette évaluation est-elle susceptible d'être choisie comme la meilleure.

Backward compatibility note

In Workshop 1.x this case of exactly two assessors with the same weight is not handled properly and leads to wrong results as only the one of them is lucky to get 100% and the second gets a lower grade.

It's not final grades that are compared

It is very important to know that the grading evaluation subplugin Comparison with the best assessment does not compare the final grades. Regardless of the grading strategy used, every filled assessment form can be seen as an n-dimensional vector of normalized values. So the subplugin compares responses to all assessment form dimensions (criteria, assertions, ...). Then it calculates the distance of two assessments, using the variance statistics.

To demonstrate this with an example, let us say you use the grading strategy Number of errors to peer-assess research essays. This strategy uses a simple list of assertions and the reviewer (assessor) just checks if the given assertion is passed or failed. Let us say you define the assessment form using three criteria:

- Does the author state the goal of the research clearly? (yes/no)

- Is the research methodology described? (yes/no)

- Are references properly cited? (yes/no)

Let us say the author gets 100% grade if all criteria are passed (that is answered "yes" by the assessor), 75% if only two criteria are passed, 25% if only one criterion is passed and 0% if the reviewer gives 'no' for all three statements.

Now imagine the work by Daniel is assessed by three colleagues - Alice, Bob and Cindy. They all give individual responses to the criteria in order:

- Alice: yes / yes / no

- Bob: yes / yes / no

- Cindy: no / yes / yes

As you can see, they all gave 75% grade to the submission. But Alice and Bob agree in individual responses, too, while the responses in Cindy's assessment are different. The evaluation method Comparison with the best assessment tries to imagine, how a hypothetical absolutely fair assessment would look like. In the Development:Workshop 2.0 specification, David refers to it as "how would Zeus assess this submission?" and we estimate it would be something like this (we have no other way):

- Zeus 66% yes / 100% yes / 33% yes

Then we try to find those assessments that are closest to this theoretically objective assessment. We realize that Alice and Bob are the best ones and give 100% grade for assessment to them. Then we calculate how much far Cindy's assessment is from the best one. As you can see, Cindy's response matches the best one in only one criterion of the three so Cindy's grade for assessment will not be as high.

The same logic applies to all other grading strategies, adequately. The conclusion is that the grade given by the best assessor does not need to be the one closest to the average as the assessments are compared at the level of individual responses, and not the final grades.

Groups and Workshop

When a workshop is used in a course using separate or visible groups and groupings, it is possible to filter by group in a drop-down menu at the Assessment phase, manual allocation page, grades report and so on.

Voir aussi

- Example workshop with data Log in with username teacher/password moodle and explore the grading and phases of a completed workshop on the Moodle School demo site.

- Research paper Moodle Workshop activities support peer review in Year 1 Science: present and future by Julian M Cox, John Paul Posada and Russell Waldron

- Using Moodle Workshop module forum

- Using Moodle forum discussion [1] where David explains a particular Workshop results

- Moodle Workshop 2.0 - a (simplified) explanation presentation by Mark Drechsler

- Development:Workshop for more information on the module infrastructure and ways how to extend provided functionality by developing own Workshop subplugins

- A Brief Journey into the Moodle 2.0 Workshop from moodlefairy's blog.