Detaillierte Dokumentation zum Fragetyp Musterabgleich: Unterschied zwischen den Versionen

| Detaillierte Dokumentation zum Fragetyp Musterabgleich | |

|---|---|

| Typ | Fragetyp |

| Set | N/A |

| Downloads | https://moodle.org/plugins/qtype_pmatch |

| Issues | https://github.com/moodleou/moodle-qtype_pmatch |

| Diskussion | https://moodle.org/mod/forum/view.php?id=737 |

| Maintainer | Tim Hunt |

Keine Bearbeitungszusammenfassung |

Keine Bearbeitungszusammenfassung |

||

| (31 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

{{ | {{Infobox Plugin | ||

|type = Fragetyp | |||

|entry = https://moodle.org/plugins/qtype_pmatch | |||

|tracker = https://github.com/moodleou/moodle-qtype_pmatch | |||

|discussion = https://moodle.org/mod/forum/view.php?id=737 | |||

|maintainer = [http://moodle.org/user/view.php?id=93821&course=5 Tim Hunt] | |||

|float = right | |||

}} | |||

{{Fragen}} | |||

==Einführung== | |||

Mit dem [[Fragetyp Musterabgleich]] kann man prüfen, ob eine kurze Freitext-Antwort einem vorgegebenen Antwortmuster entspricht. | |||

* | Dieser Fragetyp ist eine technisch ausgefeilte Alternative zum [[Fragetyp Freitext]], die Folgendes bietet: | ||

* | *die Möglichkeit, Rechtschreibfehler abzufangen (mit und ohne Englisch-Wörterbuch) | ||

* flexible | * die Angabe von Synonymen und alternativen Wortgruppen | ||

* | * eine flexible Reihenfolge der Wörter | ||

* die Prüfung der Wortverwandschaft | |||

Für bestimmte Typen von Antworteingaben konnte nachgewiesen werden, dass der automatisierte Musterabgleich ähnlich genau ist, wie eine Korrektur durch Menschen. | |||

Der Musterabgleich basiert darauf, dass Sie eine Antworteingabe mit einer Anzahl von vorgegebenen Antwortmustern abgleichen. Die einzelnen Antwortmuster werden der Reihe nach mit der Antworteingabe verglichen, bis eine Übereinstimmung gefunden. Danach erfolgt die Zuweisung einer Bewertung und eines Feedbacks. ist | |||

Der "Knackpunkt" beim Musterabgleich besteht darin, dass Sie zu einer Frage von diesem Typ passende Antworten formulieren können, die zu einer korrekten Bewertung führen. Entsprechend muss der Kern der Frage formuliert werden. | |||

[[File: | [[File:basiseinheiten.png|700px]] | ||

== | ==Konfiguration einer Frage== | ||

''' | ===Allgemeines=== | ||

'''Fragetitel''': Geben Sie der Frage einen geeigneten Namen. Teilnehmer/innen sehen diesen Fragetitel nicht. | |||

''' | '''Fragetext''': Geben Sie hier Ihre Frage ein. Sie können bei der Eingabe alle Funktionalitäten des Texteditors verwenden. | ||

[[File: | [[File:fragetext.png|700px]] | ||

Sie können den Antworteingabe-Bereich als "Lücke" innerhalb der Frage plazieren, indem Sie eine Folge von mindestens fünf Unterstrichen in den Fragetext einfügen. Zur Laufzeit (also bei der Anzeige der Frage) werden die Unterstriche durch einen Antworteingabe-Bereich ersetzt. Sie können die Größe des Antworteingabe-Bereichs näher spezifizieren, indem Sie __XxY__ angeben. Zum Beispiel erzeugt die Angabe __20x1__ einen Antworteingabe-Bereich von 20 Zeichen Breite und 1 Zeichen Höhe. Wenn Sie keine Unterstriche in Ihren Fragetext einbauen, dann wird der Antworteingabe-Bereich zur Laufzeit automatisch unterhalb des Fragetextes erzeugt. | |||

''' | '''Erreichbare Punkte''': Geben Sie an, wie viele Punkte es für die richtige Beantwortung der Frage gibt. | ||

''' | '''Allgemeines Feedback''': Wir empfehlen, als Feedback die richtige Antwort mit einer angemessenen Erklärung zu geben. Dieses Feedback wird allen Teilnehmer/innen angezeigt, unabhängig davon, ob ihre individuelle Antwort richtig oder falsch war. Beim Fragetyp Musterabgleich können Sie sich nicht auf eine maschinell generierte "richtige Antwort" (gemäß der iCMA Definition) verlassen. | ||

Die richtige Antwort im Feedback dient gleichzeitig als erstes Muster, mit dem die Antworteingabe der Teilnehmer/innen verglichen wird. | |||

[[File: | [[File:allgemeinesfeedback.png|700px]] | ||

'''Hinweis''': Die $$-Zeichen sind eine [[TeX-Notation]]. Der Ausdruck zwischen den $$-Zeichen wird mit Hilfe eines [[:Kategorie:Mathematik|mathematischen]] [[Filter]]s dargestellt (der installiert und aktiviert sein muss). | |||

=== | ===Antwortmöglichkeiten=== | ||

[[File: | [[File:antwortmöglichkeiten.png|700px]] | ||

''' | '''Groß- und Kleinschreibung''': Nein oder Ja. | ||

''' | '''Benutzung von tiefgestellten Buchstaben erlauben''': Nein oder Ja. Alle Indizes, die von Teilnehmer/innen eingeben werden, sind in den Antworteingaben zwischen den Standard-Tags <nowiki><sub></nowiki> und <nowiki></sub></nowiki> oder <nowiki><sup></nowiki> und <nowiki></sup></nowiki> zu finden. Beispiele: | ||

* | * Die Eingabe: ''Die chemische Formel für Wasser ist <nowiki>H<sub>2</sub>O</nowiki>'' resultiert in: | ||

** | ** ''Die chemische Formel für Wasser ist H<sub>2</sub>O'' | ||

* | * Die Eingabe: ''Die Lichtgeschwindigkeit beträgt ungefähr <nowiki>3x10<sup>8</sup> m s<sup>-1</sup></nowiki>'' resultiert in: | ||

** | ** ''Die Lichtgeschwindigkeit beträgt ungefähr 3x10<sup>8</sup> m s<sup>-1</sup>'' | ||

Zur Laufzeit können Tastaturnutzer/innen mit Hilfe der Pfeil-hoch / Pfeil-runter-Tasten zwischen normal, tiefgestellt und hochgestellt hin und her wechseln. Vielleicht möchten Sie diese Information in Ihrer Frage hinzufügen. | |||

''' | '''Wenn die Antwort länger als 20 Wörter ist''': Wir empfehlen dringend, die Antworteingabe auf 20 Wörter zu begrenzen. Wenn Sie beliebig lange Antworten zulassen, dann führt das häufig zu Eingaben, die zum Teil richtig und zum Teil falsch sind. Es ist schwierig, solche Eingabe konsistent zu bewerten. | ||

''' | '''Rechtschreibung des Teilnehmers prüfen''': Wie viele Schreibweisen gibt es für das Wort "Temperatur"? Wir haben in unseren Testversuchen 14 verschiedene gesehen! Sie verbessern die Korrektheit der Bewertung, wenn Sie darauf bestehen, dass die verwendeten Wörtern im Moodle System Wörterbuch stehen müssen. | ||

''' | '''Diese Wörter zum Wörterbuch hinzufügen''': Wenn es bei einer Frage um Spezialwissen oder technische oder medizinische Fachbegriffe geht, die in einem Standard-Wörterbuch nicht vorkommen, dann können Sie diese Wörter hier ergänzen. Tragen Sie die Wörter mit Leerzeichen getrennt ein. | ||

''' | '''Folgende Zeichen in Leerzeichen umwandeln''': Beim Musterabgleich sind Wörter als Zeichenfolgen definiert, die durch Leerzeichen begrenzt werden. Fragezeichen und Ausrufezeichen können ebenfalls verwendet werden, um das Ende eines Wortes zu markieren. Das Zeichen . (Punkt) ist ein Sonderfall. Als Satzendezeichen markiert er ebenfalls das Ende eines Wortes, als Dezimalpunkt in Kommazahlen jedoch nicht. Alle anderen Satzzeichen werden als Teil der Antworteingabe betrachtet. Sie können sie jedoch hier eintragen, dann werden Sie durch Leerzeichen ersetzen. | ||

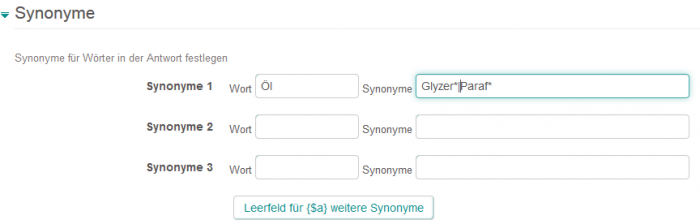

===Synonyme=== | |||

Die folgenden Synonyme gehören zur Öl-Wasser-Gemisch-Frage oben. | |||

[[File:synonyme.png|700px]] | |||

'''Wort und Synonyme''': Hier können Sie Synonyme für einzelne Wörter angeben. Sie müssen keine vollständigen Wörter als Synonyme angeben, sondern können Wildcards verwenden. | |||

Sie können nur einzelne Wörter als Synonyme angeben; ganze Wortgruppen sind nicht erlaubt. | |||

Im obigen Beispiel wird zuerst das Wort '''Öl''' überall in der Antworteingabe durch '''Öl|Glyzer*|Paraf*''' ersetzt. Erst danach erfolgt der Musterabgleich. | |||

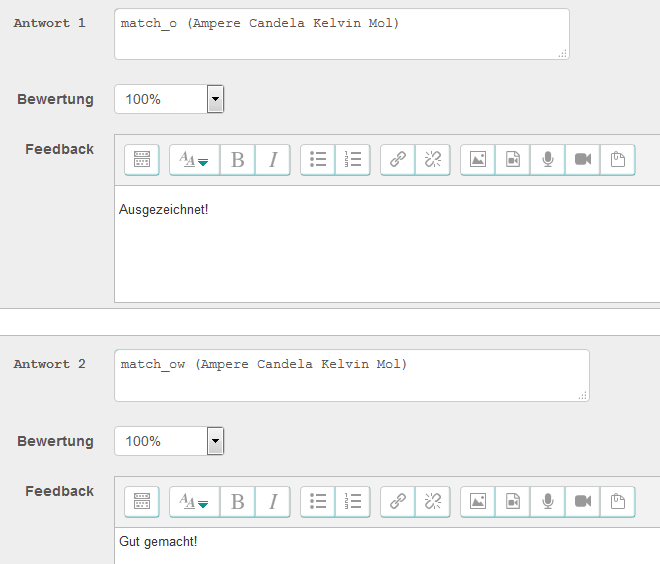

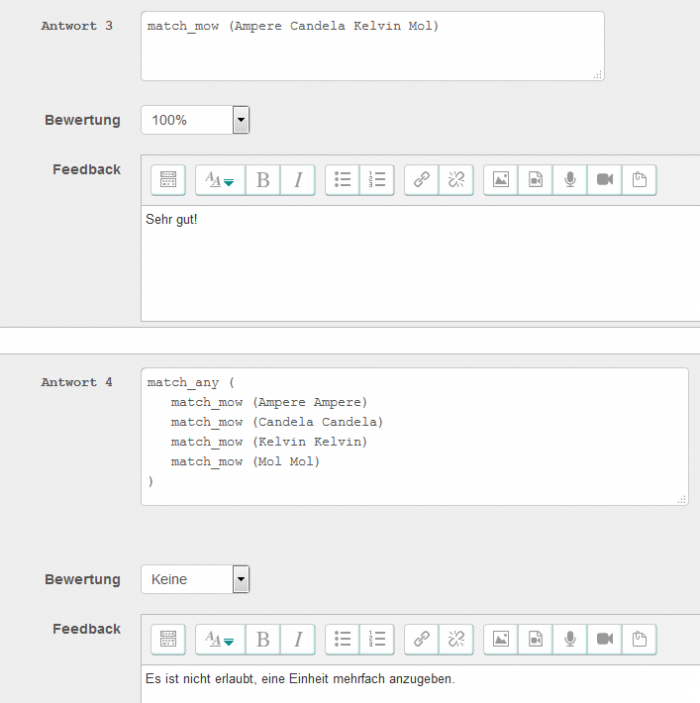

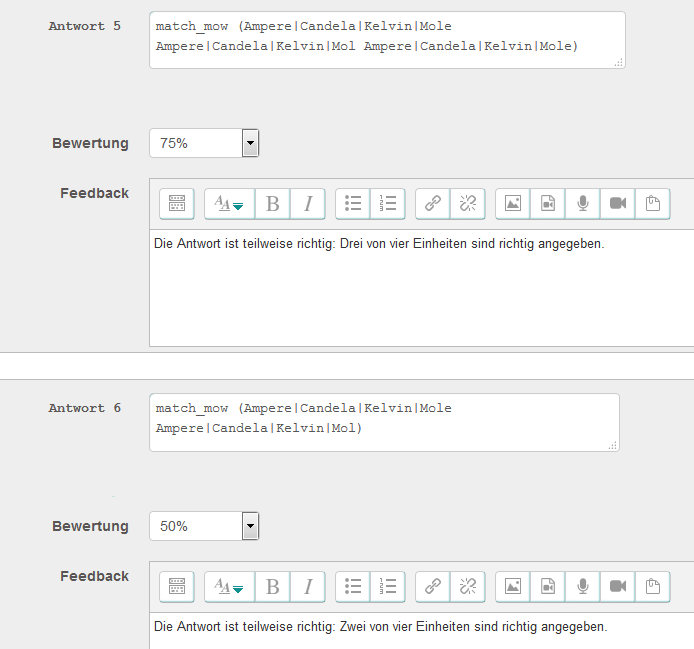

===Antworten=== | |||

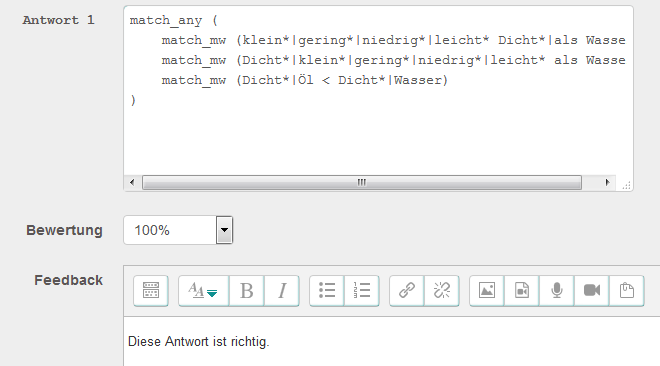

Die folgenden Antwortvorgaben für den Musterabgleich gehören zur SI-Basiseinheiten-Frage oben. | |||

[[File:antwort1.png|700px]] | |||

[[File:antwort2.png|700px]] | |||

[[File:antwort3.png|700px]] | |||

Im ersten Antwortfeld '''Antwort 1''' steht das Muster '''match_o (Ampere Candela Kelvin Mol )''', das die vier Wörter der richtigen Lösung exakt angibt. Die Option '''_o''' bedeutet, dass die Reihenfolge dieser Wörter in der Antworteingabe der Teilnehmer/innen beliebig sein darf. Das zweite Antwortfeld '''Antwort 2''' enthält ein Muster, das dieselben vier Wörter als Antworteingabe verlangt. Die Option '''_ow''' bedeutet, dass (wie bei Antwort 1) die Reihenfolge der Wörter beliebig ist und zusätzlich weitere Wörter in der Antworteingabe erlaubt sind. Das dritte Antwortfeld '''Antwort 3''' erlaubt mit der Option '''_mow''' neben der beliebigen Reihenfolge und zusätzlichen Wörtern auch Rechtschreibfehler, solange das falsch geschriebene Wort im Wörterbuch vorkommt (z.B. Kevin statt Kelvin). Zur Erklärung der Antwortfelder 4-6 finden Sie weiter unten ausführliche Beschreibungen. | |||

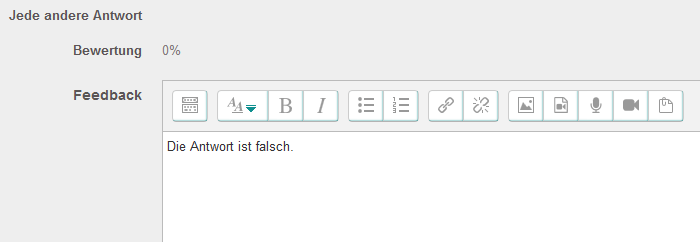

Die Antwortvorgaben für den Musterabgleich zur Öl-Wasser-Gemisch-Aufgabe könnten so aussehen: | |||

[[File:antwortwasseröl.png|700px]] | |||

''' | Im ersten Antwortfeld '''Antwort 1''' werden drei Muster verwendet, die jeweils mehrere Wörter als Alternativen angeben. Das erste Muster '''match_mw (klein*|gering*|niedrig*|leicht* Dicht*|als Wasser) akzeptiert als Antworteingabe ''Öl ist leichter als Wasser'' oder ''Öl hat eine geringere Dichte''. | ||

''' | '''Antwort''': Beide Beispiele zeigen, dass der Fragetyp Musterabgleich komplexe Muster als Antwortvorgaben unterstützt. Detaillierte Informationen zu den Mustern finden Sie weiter unten in diesem Artikel. | ||

'''Bewertung''': Geben Sie hier eine Bewertung zwischen 0 und 100%. Mindestens eine Antwortvorgabe muss mit 100% bewertet werden. | |||

'''Feedback''': Dieses spezifische Feedback wird den Teilnehmer/innen angezeigt, wenn ihre Antworteingabe dem angegebenen Muster entspricht. Das Feed feedback für alle Antworteingaben, die keinem der angegebenen Muster entsprechen und damit falsche Antworteingaben sind, wird im Antwortfeld '''Jede andere Antwort''' eingetragen. | |||

[[File: | [[File:falscheantwort.png|700px]] | ||

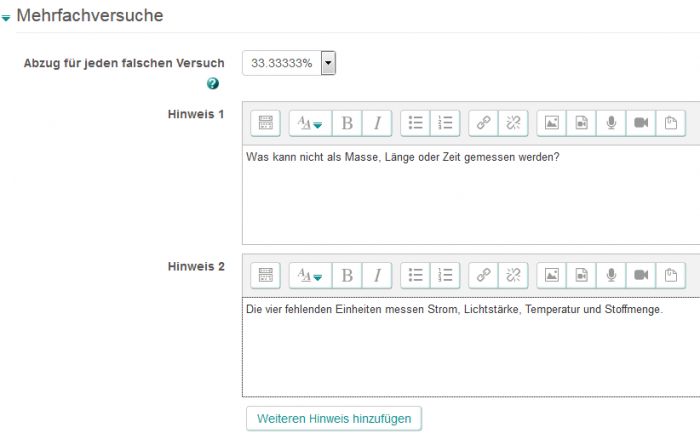

== | ===Mehrfachversuche=== | ||

[[File:mehrfachversuche.png|700px]] | |||

==Wie die Antworteingabe verarbeitet wird== | |||

Die kleinste Einheit einer Teilnehmerantwort, auf der der Musterabgleich arbeitet, ist ein Wort. Ein Wort ist dabei definiert als eine Folge von Zeichen zwischen zwei Leerzeichen. Ein Punkt (aber nicht der Dezimalpunkt in Kommazahlen), ein Fragezeichen und ein Ausrufezeichen werden ebenfalls als Ende eines Wortes behandelt. | |||

Zahlen sind in diesem Sinne besondere Formen von Wörtern. Der Abgleich erfolgt über den Wert der Zahl und nicht über die Zeichnefolge. Zum Beispiel fängt das Muster '''match_w(25 ms<sup>-1</sup>)''' folgende richtige Antworten ab: 25 ms-1, 2.5e1 ms-1, 2.5x10-1 ms-1 | |||

Mit Ausnahme von Zahlen und Wortendezeichen (Leerzeichen, Punkt, Fragezeichen, Ausrufezeichen) basiert der Musterabgleich auf dem 1-1-Abgleich der gegebenen Zeichenfolge. Darüber hinaus können Sie entscheiden, ob Groß-/Kleinschreibung berücksichtigt wird und wie Satzzeichen (, ; :) behandelt werden. | |||

Die Antworteingabe wird insgesamt behandelt. Wörter, die als verwandt hinterlegt sind, müssen jedoch im selben Satz vorkommen, damit die Antworteingabe als "richtig" bewertet wird. | |||

==PMatch-Syntax== | |||

Eine Regel umfasst drei Bestandteile. | |||

# Musterabgleich-Optionen, z.B. '''mow''' | |||

# Wörter, mit denen die Antworteingabe der Teilnehmer/innen abgeglichen wird, z.B. '''tom dick harry''' | |||

# AND (UND)-, OR (ODER) und NOT (NICHT)-Kombinationen von Wörtern zum Musterabgleich; z.B. bedeutet '''match_any()''', dass ein beliebiges der angegebenen Wörter in der Antworteingabe vorkommen muss (was einer ODER-Kombination der angegebenen Wörter entspricht). | |||

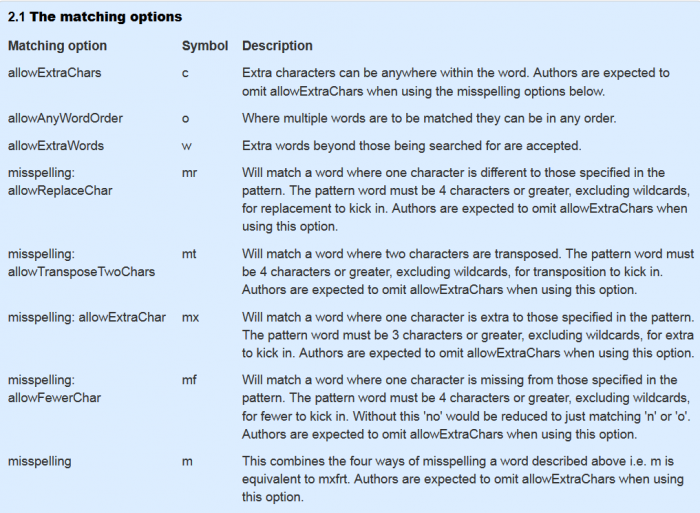

[[File:the matching options | ==Optionen für den Musterabgleich== | ||

[[File:the matching options top.png|700px]] | |||

[[File:the matching options bottom.png|700px]] | |||

Die Optionen für den Musterabgleich werden mit einem Unterstrich an das Regelwort '''match''' angehängt. Sie können mehrere Optionen kombinieren. Eine typische Kombination ist '''mow''', d.h. die Regel lautet dann '''match_mow(<''Wörter zum Abgleich''>)'''. Diese Regel | |||

# fängt Rechtschreibfehler ab, | |||

# erlaubt eine beliebige Reihenfolge der angegebenen Wörter und | |||

# erlaubt zusätzliche Wörter. | |||

==Sonderzeichen== | |||

[[File:Special characters.png|700px]] | |||

Wenn Sie Sonderzeichen abgleichen wollen, dann müssen Sie diesen Zeichen ein '\' voranstellen. Die Regel '''match(\|)''' prüft, ob in der Antworteingabe ein '|'-Zeichen vorkommt. Wenn Sie prüfen wollen, ob in der Antworteingabe runde Klammern '()' vorkommen, dann muss die Regel '''match(\(\))''' lauten. | |||

== | ==Kombinationen== | ||

[[File: | [[File:Combining matches.png|700px]] | ||

Die Regeln '''match_all()''', '''match_any()''' und '''not()''' können verschachtelt sein. | |||

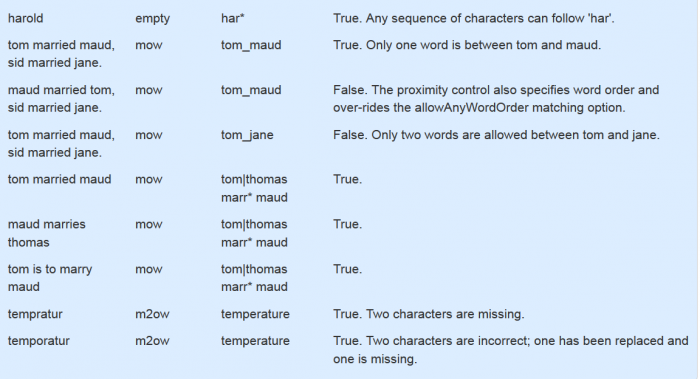

== | ==Beispiele== | ||

[[File: | [[File:Patternmatch examples top.png|700px]] | ||

[[File:Patternmatch examples bottom.png|700px]] | |||

==Hinweise zum Erstellen von Musterabgleich-Regeln== | |||

Wie können Sie mögliche Antworten der Kursteilnehmer/innen vorhersehen? Bei der großen Vielfalt von Antwortmöglichkeiten ist das natürlich schwierig, aber Sie können die verschiedenen Antwort sammeln und so über die Zeit eine "Antwort-Datenbank" aufbauen und darauf basierend Ihre Antwortvorgaben und Musterantworten formulieren. | |||

Bevor wir den Musterabgleich beschreiben, möchten wir folgende wichtige Punkte hervorheben: | |||

# Der Ausgangspunkt ist eine Frage, bei der Sie sicher sind, eine richtige Bewertung geben zu können. | |||

# Die Formulierung der Frage hat eine große Bedeutung. | |||

# Musterabgleich funktioniert am besten, wenn Sie eine einzelne Erklärung abfragen, die Sie einfach mit "richtig" oder "falsch" bewerten können. Es ist ungleich schwerer und komplexer, in einer Frage mehrere Teilaspekte zu formulieren und diese mit Teilpunkten zu bewerten. Besser ist es, jeden Teilaspekt in einer eigenen Frage zu formulieren. | |||

# Eine Sammlung von Antworten von realen Teilnehmer/innen und deren Bewertung ist ein bedeutender Ausgangspunkt für einen Musterabgleich. Um eine solche Sammlung von möglichen Antworten aufzubauen, können Sie vorab dieselbe Frage als Freitextfrage oder Aufgabenabgabe stellen und manuell bewerten. | |||

# Der Fragetyp Musterabgleich erfordert (mehr als alle anderen Fragetypen), dass Sie die Antworten Ihrer Teilnehmer/innnen kontinuierlich überwachen und Ihre Antwortvorgaben und Musterantworten regelmäßig überprüfen und bei Bedarf anpassen. Es wird ein Zeitpunkt kommen, an dem Sie glauben, dass Ihre Musterantwort "hinreichend gut" ist. Oder Sie fragen sich, wie viele Antworten von Teilnehmer/innen nötig sind, um zu diesem Punkt zu gelangen. Leider gibt es darauf keine allgemein gültige Antwort. Manchmal reichen 200 Antworten, manchmal sind wesentlich mehr Antworten nötig. Auf jeden Fall sollten Sie folgende Punkte bedenken: | |||

## Es verlangt mehr von den Teilnehmer/innen, wenn sie eine Antwort selbst formulieren müssen, als wenn sie nur aus einer Liste von vorgegebenen Antwortoptionen auswählen müssen. | |||

## Bewerter/innen, die mit einem Bewertungsschema arbeiten, können dennoch Fehler machen. | |||

# Eine akzeptierte Methodebeim Musterabgleich ist die Verwendung von Platzhaltern für Endungen, z.B. ''beweg*'' für ''bewegen'', ''bewegung'', ''bewegte'' usw. | |||

# Teilnehmer/innen geben normalerweise keine vorsätzlich falschen Antworten. Warum sollten sie? (Im Gegensatz zu Wissenschaftler/innen, die möglicherweise versuchen, dass System zu überlisten.) Teilnehmer/innen werden kaum eine richtige Antwort eingeben, der ein "Die Antwort ist nicht:" vorangestellt ist. Solche Antwortmuster müssen Sie also nicht "abfangen". | |||

# Achten Sie auf Wortverwandschaften, um ähnliche Wörter und Synonyme zu berücksichtigen. | |||

# Wenn Sie offensichtlich falsche Antworten frühzeitig in Ihrem Musterabgleich abfangen und bewerten, führt das meistens zu einer insgesamt besseren Korrektheit der Bewertung. | |||

# Antworten, die sowohl richtige als auch falsche Aspekte beinhalten, erfordern ein genaueres Hinsehen. Sie sollten solche Antworten einheitlich als "richtig" oder "falsch" bewerten. Der Computer wird Ihr Bewertungsschema konsistent abarbeiten. | |||

# Sie sollten eine Korrektheit der Bewertung von >95% anstreben (in unseren Testversuchen lag die Korrektheit der Bewertung durch natürlcihe Personen bei 92%-96%). | |||

== | ==Geschichte== | ||

Das hier beschriebene Verfahren zum Musterabgleich wurde in den 1970er Jahren im Fachbereich "Computer Based Learning" der Leeds University entwickelt und in die Sprache "Leeds Author Language" integriert. Die Basiseinheit eines Worts, die Abgleichoptionen "allowAnyChars", "allowAnyWords", "allowAnyOrder" und die "Wort-OR-Funktionalität" gehen auf die "Leeds Author Language" zurück. | |||

Im Jahr 1976 veröffentlichte das CALCHEM Projekt, an dem die Computer Based Learning Unit, die Fakultät Chemie der Leeds University und das Computer Centre of Sheffield Polytechnic (heute Sheffield Hallam University) beteiligt waren, eine portable Version der Sprache "Leeds Author Language". | |||

Eine portable Version für Kleincomputers wurde im Jahr 1982 von der Open University, der Midland Bank (heute ist Midland Teil der HSBC) und dem Imperial College entwickelt. Zu diesem Zeitpunkt wurden die Wildcards für einzelne und mehrfache Zeichen hinzugefügt. | |||

Die Berücksichtigung von Rechtschreibfehlern, die Wortverwandschaft und Wortgruppen in OR-Listen wurden im Rahmen des COLMST Projektes der Open University in den Jahren 2006 - 2009 ergänzt. | |||

== | ==Literaturhinweise== | ||

Philip G. Butcher and Sally E. Jordan, A comparison of human and computer marking of short free-text student responses, Computers & Education 55 (2010) 489-499 | Philip G. Butcher and Sally E. Jordan, A comparison of human and computer marking of short free-text student responses, Computers & Education 55 (2010) 489-499 | ||

Diese Informationen entstammen der Seite [http://www.open.edu/openlearnworks/mod/oucontent/view.php?id=52747§ion=2.2.1 http://www.open.edu/openlearnworks/mod/oucontent/view.php?id=52747§ion=2.2.1] vom 17.09.2014. | |||

== | ==Siehe auch== | ||

* [[ | * [[Fragetyp Musterabgleich]] | ||

[[Category: | [[Category:Test]] | ||

[[Category: | [[Category:Fragen]] | ||

[[en:Pattern-match_question_type_detailed_documentation]] | [[en:Pattern-match_question_type_detailed_documentation]] | ||

Aktuelle Version vom 27. Februar 2019, 14:27 Uhr

- Fragen verwalten

- Frageverhalten

- Fragetypen

- Berechnet

- Drag-and-Drop auf Bild

- Drag-and-Drop Markierungen

- Drag-and-Drop auf Text

- Einfach berechnet

- Berechnete Multiple-Choice

- Beschreibung

- Freitext

- Lückentext (Cloze)

- Lückentextauswahl

- Multiple-Choice

- Kurzantwort

- Numerisch

- Wahr/Falsch

- Zuordnung

- Zufällige Kurzantwortzuordnung

- Third-Party Fragetypen

- Fragen FAQ

Einführung

Mit dem Fragetyp Musterabgleich kann man prüfen, ob eine kurze Freitext-Antwort einem vorgegebenen Antwortmuster entspricht.

Dieser Fragetyp ist eine technisch ausgefeilte Alternative zum Fragetyp Freitext, die Folgendes bietet:

- die Möglichkeit, Rechtschreibfehler abzufangen (mit und ohne Englisch-Wörterbuch)

- die Angabe von Synonymen und alternativen Wortgruppen

- eine flexible Reihenfolge der Wörter

- die Prüfung der Wortverwandschaft

Für bestimmte Typen von Antworteingaben konnte nachgewiesen werden, dass der automatisierte Musterabgleich ähnlich genau ist, wie eine Korrektur durch Menschen.

Der Musterabgleich basiert darauf, dass Sie eine Antworteingabe mit einer Anzahl von vorgegebenen Antwortmustern abgleichen. Die einzelnen Antwortmuster werden der Reihe nach mit der Antworteingabe verglichen, bis eine Übereinstimmung gefunden. Danach erfolgt die Zuweisung einer Bewertung und eines Feedbacks. ist

Der "Knackpunkt" beim Musterabgleich besteht darin, dass Sie zu einer Frage von diesem Typ passende Antworten formulieren können, die zu einer korrekten Bewertung führen. Entsprechend muss der Kern der Frage formuliert werden.

Konfiguration einer Frage

Allgemeines

Fragetitel: Geben Sie der Frage einen geeigneten Namen. Teilnehmer/innen sehen diesen Fragetitel nicht.

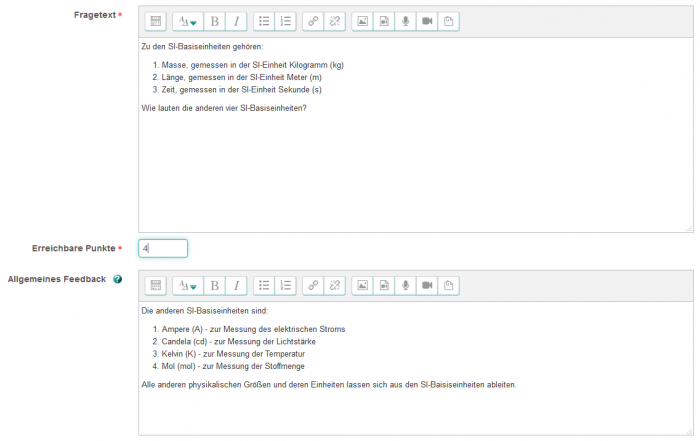

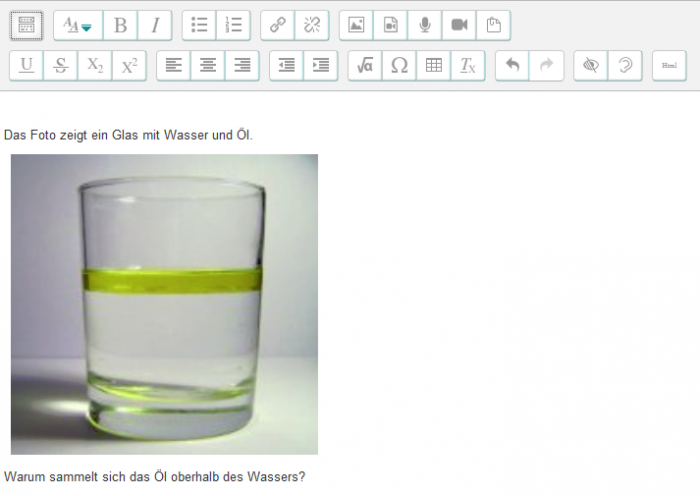

Fragetext: Geben Sie hier Ihre Frage ein. Sie können bei der Eingabe alle Funktionalitäten des Texteditors verwenden.

Sie können den Antworteingabe-Bereich als "Lücke" innerhalb der Frage plazieren, indem Sie eine Folge von mindestens fünf Unterstrichen in den Fragetext einfügen. Zur Laufzeit (also bei der Anzeige der Frage) werden die Unterstriche durch einen Antworteingabe-Bereich ersetzt. Sie können die Größe des Antworteingabe-Bereichs näher spezifizieren, indem Sie __XxY__ angeben. Zum Beispiel erzeugt die Angabe __20x1__ einen Antworteingabe-Bereich von 20 Zeichen Breite und 1 Zeichen Höhe. Wenn Sie keine Unterstriche in Ihren Fragetext einbauen, dann wird der Antworteingabe-Bereich zur Laufzeit automatisch unterhalb des Fragetextes erzeugt.

Erreichbare Punkte: Geben Sie an, wie viele Punkte es für die richtige Beantwortung der Frage gibt.

Allgemeines Feedback: Wir empfehlen, als Feedback die richtige Antwort mit einer angemessenen Erklärung zu geben. Dieses Feedback wird allen Teilnehmer/innen angezeigt, unabhängig davon, ob ihre individuelle Antwort richtig oder falsch war. Beim Fragetyp Musterabgleich können Sie sich nicht auf eine maschinell generierte "richtige Antwort" (gemäß der iCMA Definition) verlassen.

Die richtige Antwort im Feedback dient gleichzeitig als erstes Muster, mit dem die Antworteingabe der Teilnehmer/innen verglichen wird.

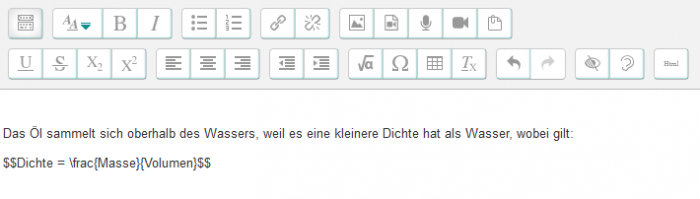

Hinweis: Die $$-Zeichen sind eine TeX-Notation. Der Ausdruck zwischen den $$-Zeichen wird mit Hilfe eines mathematischen Filters dargestellt (der installiert und aktiviert sein muss).

Antwortmöglichkeiten

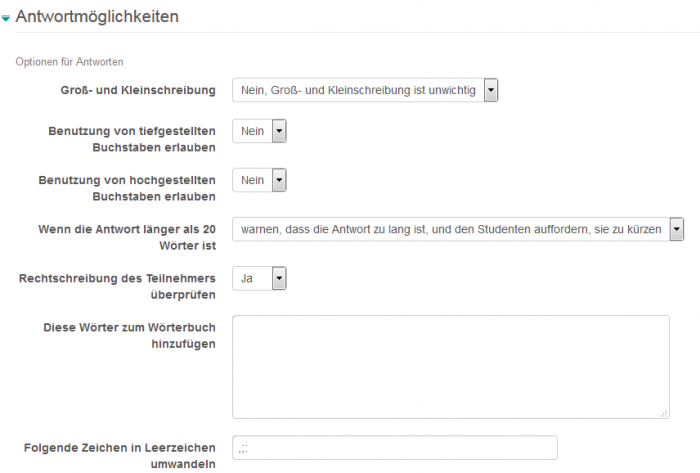

Groß- und Kleinschreibung: Nein oder Ja.

Benutzung von tiefgestellten Buchstaben erlauben: Nein oder Ja. Alle Indizes, die von Teilnehmer/innen eingeben werden, sind in den Antworteingaben zwischen den Standard-Tags <sub> und </sub> oder <sup> und </sup> zu finden. Beispiele:

- Die Eingabe: Die chemische Formel für Wasser ist H<sub>2</sub>O resultiert in:

- Die chemische Formel für Wasser ist H2O

- Die Eingabe: Die Lichtgeschwindigkeit beträgt ungefähr 3x10<sup>8</sup> m s<sup>-1</sup> resultiert in:

- Die Lichtgeschwindigkeit beträgt ungefähr 3x108 m s-1

Zur Laufzeit können Tastaturnutzer/innen mit Hilfe der Pfeil-hoch / Pfeil-runter-Tasten zwischen normal, tiefgestellt und hochgestellt hin und her wechseln. Vielleicht möchten Sie diese Information in Ihrer Frage hinzufügen.

Wenn die Antwort länger als 20 Wörter ist: Wir empfehlen dringend, die Antworteingabe auf 20 Wörter zu begrenzen. Wenn Sie beliebig lange Antworten zulassen, dann führt das häufig zu Eingaben, die zum Teil richtig und zum Teil falsch sind. Es ist schwierig, solche Eingabe konsistent zu bewerten.

Rechtschreibung des Teilnehmers prüfen: Wie viele Schreibweisen gibt es für das Wort "Temperatur"? Wir haben in unseren Testversuchen 14 verschiedene gesehen! Sie verbessern die Korrektheit der Bewertung, wenn Sie darauf bestehen, dass die verwendeten Wörtern im Moodle System Wörterbuch stehen müssen.

Diese Wörter zum Wörterbuch hinzufügen: Wenn es bei einer Frage um Spezialwissen oder technische oder medizinische Fachbegriffe geht, die in einem Standard-Wörterbuch nicht vorkommen, dann können Sie diese Wörter hier ergänzen. Tragen Sie die Wörter mit Leerzeichen getrennt ein.

Folgende Zeichen in Leerzeichen umwandeln: Beim Musterabgleich sind Wörter als Zeichenfolgen definiert, die durch Leerzeichen begrenzt werden. Fragezeichen und Ausrufezeichen können ebenfalls verwendet werden, um das Ende eines Wortes zu markieren. Das Zeichen . (Punkt) ist ein Sonderfall. Als Satzendezeichen markiert er ebenfalls das Ende eines Wortes, als Dezimalpunkt in Kommazahlen jedoch nicht. Alle anderen Satzzeichen werden als Teil der Antworteingabe betrachtet. Sie können sie jedoch hier eintragen, dann werden Sie durch Leerzeichen ersetzen.

Synonyme

Die folgenden Synonyme gehören zur Öl-Wasser-Gemisch-Frage oben.

Wort und Synonyme: Hier können Sie Synonyme für einzelne Wörter angeben. Sie müssen keine vollständigen Wörter als Synonyme angeben, sondern können Wildcards verwenden.

Sie können nur einzelne Wörter als Synonyme angeben; ganze Wortgruppen sind nicht erlaubt.

Im obigen Beispiel wird zuerst das Wort Öl überall in der Antworteingabe durch Öl|Glyzer*|Paraf* ersetzt. Erst danach erfolgt der Musterabgleich.

Antworten

Die folgenden Antwortvorgaben für den Musterabgleich gehören zur SI-Basiseinheiten-Frage oben.

Im ersten Antwortfeld Antwort 1 steht das Muster match_o (Ampere Candela Kelvin Mol ), das die vier Wörter der richtigen Lösung exakt angibt. Die Option _o bedeutet, dass die Reihenfolge dieser Wörter in der Antworteingabe der Teilnehmer/innen beliebig sein darf. Das zweite Antwortfeld Antwort 2 enthält ein Muster, das dieselben vier Wörter als Antworteingabe verlangt. Die Option _ow bedeutet, dass (wie bei Antwort 1) die Reihenfolge der Wörter beliebig ist und zusätzlich weitere Wörter in der Antworteingabe erlaubt sind. Das dritte Antwortfeld Antwort 3 erlaubt mit der Option _mow neben der beliebigen Reihenfolge und zusätzlichen Wörtern auch Rechtschreibfehler, solange das falsch geschriebene Wort im Wörterbuch vorkommt (z.B. Kevin statt Kelvin). Zur Erklärung der Antwortfelder 4-6 finden Sie weiter unten ausführliche Beschreibungen.

Die Antwortvorgaben für den Musterabgleich zur Öl-Wasser-Gemisch-Aufgabe könnten so aussehen:

Im ersten Antwortfeld Antwort 1 werden drei Muster verwendet, die jeweils mehrere Wörter als Alternativen angeben. Das erste Muster match_mw (klein*|gering*|niedrig*|leicht* Dicht*|als Wasser) akzeptiert als Antworteingabe Öl ist leichter als Wasser oder Öl hat eine geringere Dichte.

Antwort: Beide Beispiele zeigen, dass der Fragetyp Musterabgleich komplexe Muster als Antwortvorgaben unterstützt. Detaillierte Informationen zu den Mustern finden Sie weiter unten in diesem Artikel.

Bewertung: Geben Sie hier eine Bewertung zwischen 0 und 100%. Mindestens eine Antwortvorgabe muss mit 100% bewertet werden.

Feedback: Dieses spezifische Feedback wird den Teilnehmer/innen angezeigt, wenn ihre Antworteingabe dem angegebenen Muster entspricht. Das Feed feedback für alle Antworteingaben, die keinem der angegebenen Muster entsprechen und damit falsche Antworteingaben sind, wird im Antwortfeld Jede andere Antwort eingetragen.

Mehrfachversuche

Wie die Antworteingabe verarbeitet wird

Die kleinste Einheit einer Teilnehmerantwort, auf der der Musterabgleich arbeitet, ist ein Wort. Ein Wort ist dabei definiert als eine Folge von Zeichen zwischen zwei Leerzeichen. Ein Punkt (aber nicht der Dezimalpunkt in Kommazahlen), ein Fragezeichen und ein Ausrufezeichen werden ebenfalls als Ende eines Wortes behandelt.

Zahlen sind in diesem Sinne besondere Formen von Wörtern. Der Abgleich erfolgt über den Wert der Zahl und nicht über die Zeichnefolge. Zum Beispiel fängt das Muster match_w(25 ms-1) folgende richtige Antworten ab: 25 ms-1, 2.5e1 ms-1, 2.5x10-1 ms-1

Mit Ausnahme von Zahlen und Wortendezeichen (Leerzeichen, Punkt, Fragezeichen, Ausrufezeichen) basiert der Musterabgleich auf dem 1-1-Abgleich der gegebenen Zeichenfolge. Darüber hinaus können Sie entscheiden, ob Groß-/Kleinschreibung berücksichtigt wird und wie Satzzeichen (, ; :) behandelt werden.

Die Antworteingabe wird insgesamt behandelt. Wörter, die als verwandt hinterlegt sind, müssen jedoch im selben Satz vorkommen, damit die Antworteingabe als "richtig" bewertet wird.

PMatch-Syntax

Eine Regel umfasst drei Bestandteile.

- Musterabgleich-Optionen, z.B. mow

- Wörter, mit denen die Antworteingabe der Teilnehmer/innen abgeglichen wird, z.B. tom dick harry

- AND (UND)-, OR (ODER) und NOT (NICHT)-Kombinationen von Wörtern zum Musterabgleich; z.B. bedeutet match_any(), dass ein beliebiges der angegebenen Wörter in der Antworteingabe vorkommen muss (was einer ODER-Kombination der angegebenen Wörter entspricht).

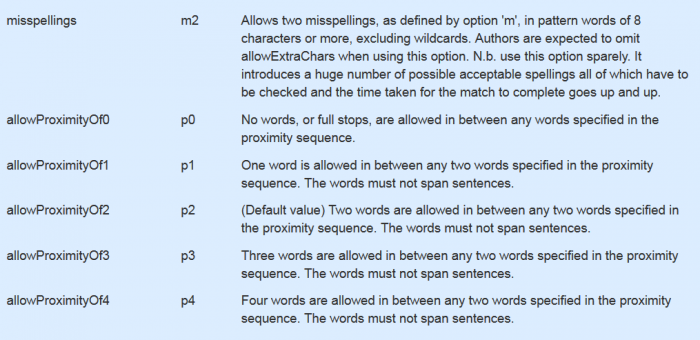

Optionen für den Musterabgleich

Die Optionen für den Musterabgleich werden mit einem Unterstrich an das Regelwort match angehängt. Sie können mehrere Optionen kombinieren. Eine typische Kombination ist mow, d.h. die Regel lautet dann match_mow(<Wörter zum Abgleich>). Diese Regel

- fängt Rechtschreibfehler ab,

- erlaubt eine beliebige Reihenfolge der angegebenen Wörter und

- erlaubt zusätzliche Wörter.

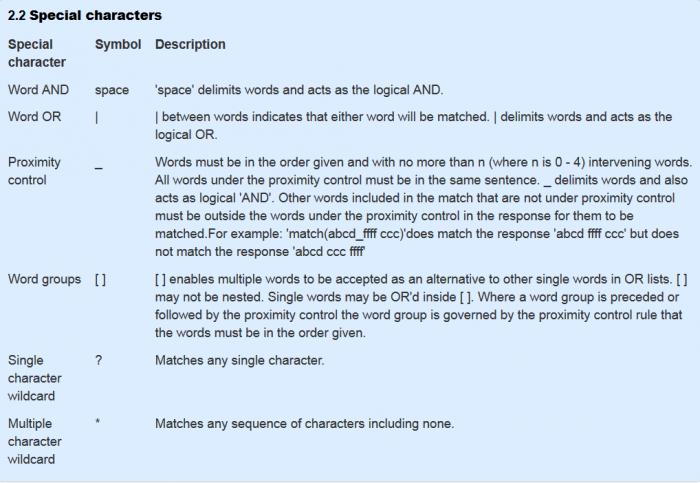

Sonderzeichen

Wenn Sie Sonderzeichen abgleichen wollen, dann müssen Sie diesen Zeichen ein '\' voranstellen. Die Regel match(\|) prüft, ob in der Antworteingabe ein '|'-Zeichen vorkommt. Wenn Sie prüfen wollen, ob in der Antworteingabe runde Klammern '()' vorkommen, dann muss die Regel match(\(\)) lauten.

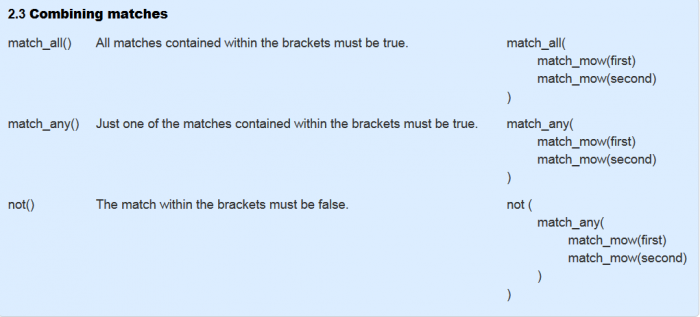

Kombinationen

Die Regeln match_all(), match_any() und not() können verschachtelt sein.

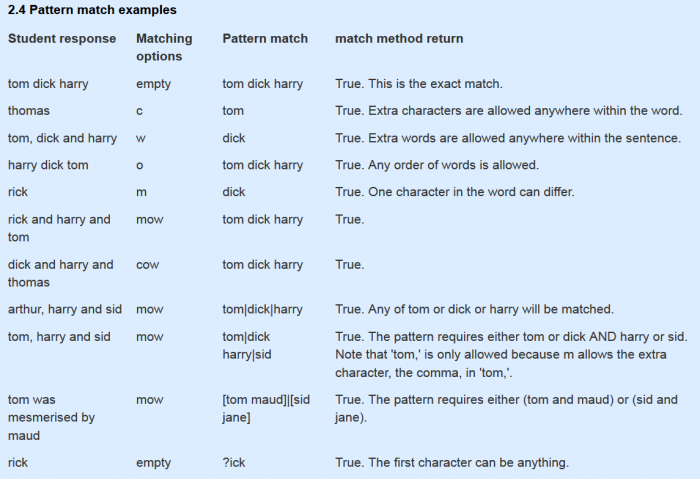

Beispiele

Hinweise zum Erstellen von Musterabgleich-Regeln

Wie können Sie mögliche Antworten der Kursteilnehmer/innen vorhersehen? Bei der großen Vielfalt von Antwortmöglichkeiten ist das natürlich schwierig, aber Sie können die verschiedenen Antwort sammeln und so über die Zeit eine "Antwort-Datenbank" aufbauen und darauf basierend Ihre Antwortvorgaben und Musterantworten formulieren.

Bevor wir den Musterabgleich beschreiben, möchten wir folgende wichtige Punkte hervorheben:

- Der Ausgangspunkt ist eine Frage, bei der Sie sicher sind, eine richtige Bewertung geben zu können.

- Die Formulierung der Frage hat eine große Bedeutung.

- Musterabgleich funktioniert am besten, wenn Sie eine einzelne Erklärung abfragen, die Sie einfach mit "richtig" oder "falsch" bewerten können. Es ist ungleich schwerer und komplexer, in einer Frage mehrere Teilaspekte zu formulieren und diese mit Teilpunkten zu bewerten. Besser ist es, jeden Teilaspekt in einer eigenen Frage zu formulieren.

- Eine Sammlung von Antworten von realen Teilnehmer/innen und deren Bewertung ist ein bedeutender Ausgangspunkt für einen Musterabgleich. Um eine solche Sammlung von möglichen Antworten aufzubauen, können Sie vorab dieselbe Frage als Freitextfrage oder Aufgabenabgabe stellen und manuell bewerten.

- Der Fragetyp Musterabgleich erfordert (mehr als alle anderen Fragetypen), dass Sie die Antworten Ihrer Teilnehmer/innnen kontinuierlich überwachen und Ihre Antwortvorgaben und Musterantworten regelmäßig überprüfen und bei Bedarf anpassen. Es wird ein Zeitpunkt kommen, an dem Sie glauben, dass Ihre Musterantwort "hinreichend gut" ist. Oder Sie fragen sich, wie viele Antworten von Teilnehmer/innen nötig sind, um zu diesem Punkt zu gelangen. Leider gibt es darauf keine allgemein gültige Antwort. Manchmal reichen 200 Antworten, manchmal sind wesentlich mehr Antworten nötig. Auf jeden Fall sollten Sie folgende Punkte bedenken:

- Es verlangt mehr von den Teilnehmer/innen, wenn sie eine Antwort selbst formulieren müssen, als wenn sie nur aus einer Liste von vorgegebenen Antwortoptionen auswählen müssen.

- Bewerter/innen, die mit einem Bewertungsschema arbeiten, können dennoch Fehler machen.

- Eine akzeptierte Methodebeim Musterabgleich ist die Verwendung von Platzhaltern für Endungen, z.B. beweg* für bewegen, bewegung, bewegte usw.

- Teilnehmer/innen geben normalerweise keine vorsätzlich falschen Antworten. Warum sollten sie? (Im Gegensatz zu Wissenschaftler/innen, die möglicherweise versuchen, dass System zu überlisten.) Teilnehmer/innen werden kaum eine richtige Antwort eingeben, der ein "Die Antwort ist nicht:" vorangestellt ist. Solche Antwortmuster müssen Sie also nicht "abfangen".

- Achten Sie auf Wortverwandschaften, um ähnliche Wörter und Synonyme zu berücksichtigen.

- Wenn Sie offensichtlich falsche Antworten frühzeitig in Ihrem Musterabgleich abfangen und bewerten, führt das meistens zu einer insgesamt besseren Korrektheit der Bewertung.

- Antworten, die sowohl richtige als auch falsche Aspekte beinhalten, erfordern ein genaueres Hinsehen. Sie sollten solche Antworten einheitlich als "richtig" oder "falsch" bewerten. Der Computer wird Ihr Bewertungsschema konsistent abarbeiten.

- Sie sollten eine Korrektheit der Bewertung von >95% anstreben (in unseren Testversuchen lag die Korrektheit der Bewertung durch natürlcihe Personen bei 92%-96%).

Geschichte

Das hier beschriebene Verfahren zum Musterabgleich wurde in den 1970er Jahren im Fachbereich "Computer Based Learning" der Leeds University entwickelt und in die Sprache "Leeds Author Language" integriert. Die Basiseinheit eines Worts, die Abgleichoptionen "allowAnyChars", "allowAnyWords", "allowAnyOrder" und die "Wort-OR-Funktionalität" gehen auf die "Leeds Author Language" zurück.

Im Jahr 1976 veröffentlichte das CALCHEM Projekt, an dem die Computer Based Learning Unit, die Fakultät Chemie der Leeds University und das Computer Centre of Sheffield Polytechnic (heute Sheffield Hallam University) beteiligt waren, eine portable Version der Sprache "Leeds Author Language".

Eine portable Version für Kleincomputers wurde im Jahr 1982 von der Open University, der Midland Bank (heute ist Midland Teil der HSBC) und dem Imperial College entwickelt. Zu diesem Zeitpunkt wurden die Wildcards für einzelne und mehrfache Zeichen hinzugefügt.

Die Berücksichtigung von Rechtschreibfehlern, die Wortverwandschaft und Wortgruppen in OR-Listen wurden im Rahmen des COLMST Projektes der Open University in den Jahren 2006 - 2009 ergänzt.

Literaturhinweise

Philip G. Butcher and Sally E. Jordan, A comparison of human and computer marking of short free-text student responses, Computers & Education 55 (2010) 489-499

Diese Informationen entstammen der Seite http://www.open.edu/openlearnworks/mod/oucontent/view.php?id=52747§ion=2.2.1 vom 17.09.2014.